论文阅读笔记:MobileNets系列论文浅析:mobilenet v2

参考原论文

参考B站视频

hint: 为了去寻找一个最优的网络架构,有哪些思考模式是可以借鉴的。哪怕我无法提出一个通用的网路架构design的创新方法,学习已有的架构设计思路来改进已有模型也是可以的,所以为了改进模型而去学习这些改进的思路是很必要的。

究竟有哪些架构优化方法呢?

核心亮点

manifold of interest

- manifold: 流形的概念:

流形学习的观点是认为,我们所能观察到的数据实际上是由一个低维流形映射到高维空间上的。由于数据内部特征的限制,一些高维中的数据会产生维度上的冗余,实际上只需要比较低的维度就能唯一地表示。参考链接:https://en.wikipedia.org/wiki/Manifold

- 举例1:实际上二维空间中的圆就是一个一维流形(维度冗余)

- 举例2:三维空间中一个球面(只需要经纬两个维度即可描述)

在深度学习领域,我们可以将激活张量视为多个容器组合而成的,每个容器包含了数量为

Linear Bottlenecks

- intuition:

- 如果我们感兴趣的流形经过relu变换后的信息不为零,那么这个变换对应的就是线性变换。

- 有没有办法,能够让我们有relu的同时,尽量不丢失必要信息呢:在高维空间做relu可以尽量保留我们所需的低维度的信息。

inverted residuals(倒残差)

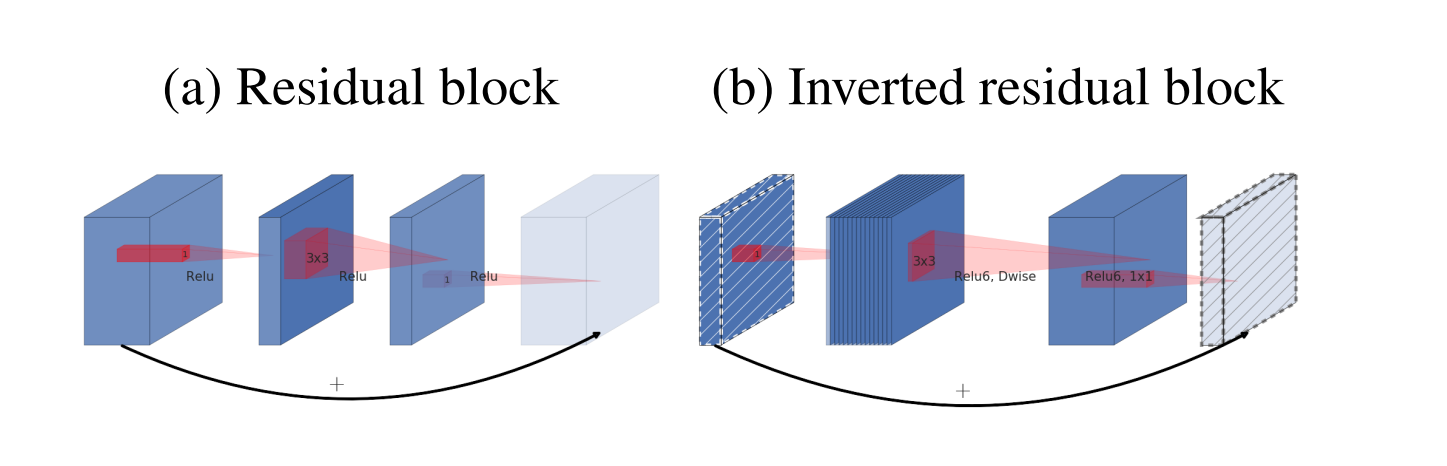

本文将残差的思想引入了mobileNet v2。传统的残差连接连的是具有较大channel数的两个层,而倒残差连接的是两个瓶颈层:

可以看出,与传统残差连接相反,倒残差的整体形状是中间宽(增加非线性变换的表达能力),两头窄(更节省内存)。

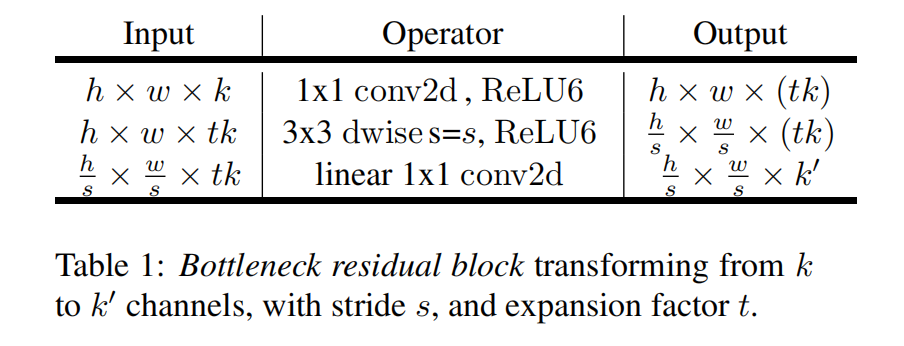

该块的实现架构如下表所示:

计算量:(乘加运算数)$hwk*t(k+3^2+k^`)$

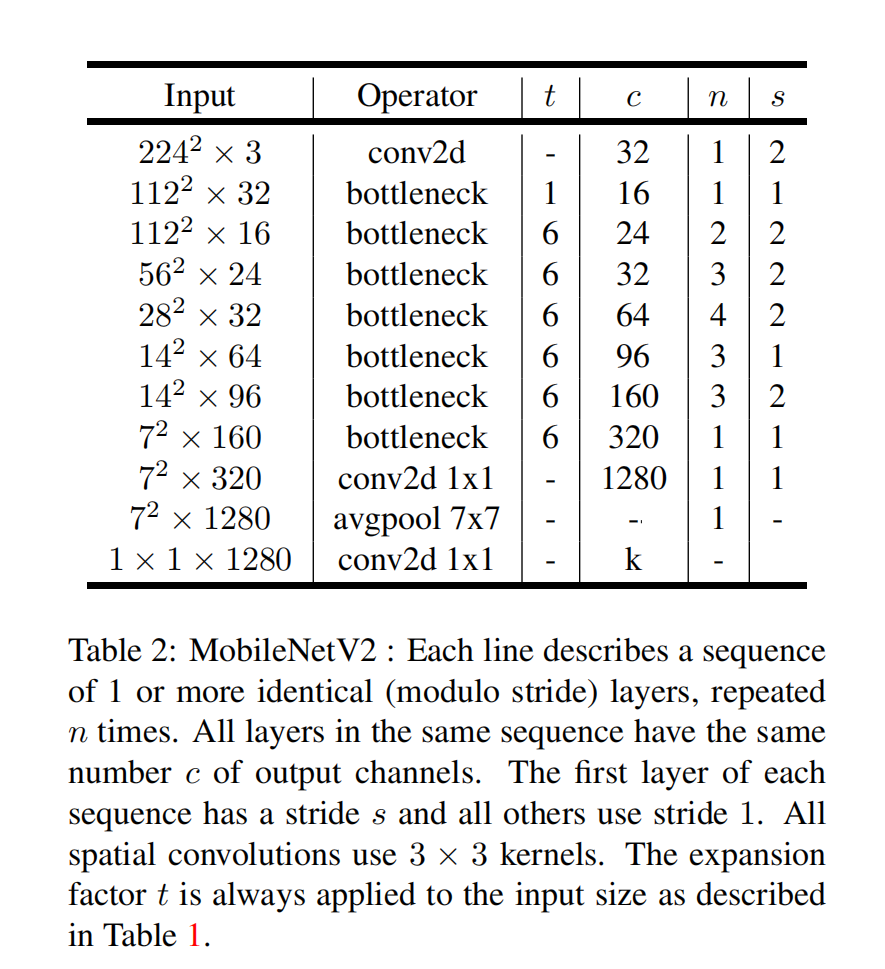

网络结构

[1] Neural architecture search with reinforcement learning. CoRR 2016

[2] Learning transferable architectures for scalable image recognition. CoRR 2017

- Post title:论文阅读笔记:“MobileNetV2:Inverted Residuals and Linear Bottlenecks”

- Post author:sixwalter

- Create time:2023-08-05 11:14:26

- Post link:https://coelien.github.io/2023/08/05/paper-reading/paper_reading_016/

- Copyright Notice:All articles in this blog are licensed under BY-NC-SA unless stating additionally.